Поставщики программного обеспечения для платформ удаленного сбора данных

Удаленный сбор данных – это уже не будущее, а настоящее. Бизнесу становится все важнее собирать информацию о своих клиентах, процессах, рынках… и делать это максимально эффективно, не ограничиваясь офисными операциями. Но как выбрать правильное программное обеспечение для этой задачи? Особенно если речь идет о платформах, предназначенных для автоматизации и масштабирования сбора данных из различных источников. В этой статье мы рассмотрим ключевых игроков на рынке поставщиков программного обеспечения для платформ удаленного сбора данных, обсудим их особенности и поможем вам сориентироваться в этом многообразии.

Что такое платформы удаленного сбора данных и зачем они нужны?

Прежде чем говорить о поставщиках, давайте разберемся, что собой представляют платформы удаленного сбора данных. По сути, это комплекс программных инструментов, позволяющих собирать информацию из различных источников – веб-сайтов, баз данных, социальных сетей, мобильных приложений, IoT-устройств и так далее – без необходимости физического присутствия или ручного ввода данных. Использование таких платформ позволяет существенно сократить время и затраты на сбор информации, повысить ее точность и получать актуальные данные в режиме реального времени.

Представьте себе ситуацию: вы – исследователь рынка. Вместо того, чтобы вручную собирать информацию о ценах конкурентов, анализировать отзывы клиентов на форумах и в социальных сетях, вы можете использовать платформу удаленного сбора данных для автоматического сбора этих данных и получения на их основе ценных инсайтов. Или, например, компания, занимающаяся мониторингом состояния оборудования: платформы удаленного сбора данных позволяют собирать данные с датчиков IoT, анализировать их и выявлять потенциальные проблемы еще до того, как они приведут к поломкам.

Ключевые требования к программному обеспечению для удаленного сбора данных

Прежде чем приступить к выбору конкретного поставщика, стоит определить, какие требования предъявляются к программному обеспечению. Вот некоторые из ключевых:

- Поддержка различных источников данных: Платформа должна поддерживать сбор данных из широкого спектра источников, включая веб-сайты, базы данных, API и другие.

- Гибкость и настраиваемость: Возможность создавать собственные сборщики данных, настраивать фильтры и правила обработки данных.

- Масштабируемость: Платформа должна выдерживать большие объемы данных и масштабироваться по мере роста ваших потребностей.

- Автоматизация: Возможность автоматизировать процесс сбора данных, включая расписание, отчетность и уведомления.

- Безопасность: Защита данных от несанкционированного доступа и утечек.

- Интеграция с другими системами: Возможность интеграции с другими инструментами, такими как CRM, ERP и BI-платформы.

Обзор основных поставщиков программного обеспечения для удаленного сбора данных

Сейчас на рынке представлено множество поставщиков программного обеспечения для платформ удаленного сбора данных. Рассмотрим наиболее популярных и заметных игроков:

Octoparse

Octoparse – это платформа для автоматизации веб-сбора данных, которая предлагает визуальный интерфейс для создания сборщиков данных без написания кода. Платформа поддерживает сбор данных с веб-сайтов, баз данных и API, а также предлагает широкие возможности для обработки и преобразования данных. Особенность Octoparse в простоте использования – даже начинающий пользователь может быстро освоить платформу и начать собирать нужные данные.

Пример использования: сбор информации о ценах на товары с нескольких интернет-магазинов. Octoparse позволяет создать сборщик данных, который будет автоматически собирать информацию о ценах, описаниях и наличии товаров, а затем сохранять ее в удобном формате.

Преимущества: Простота использования, визуальный интерфейс, широкий спектр поддерживаемых источников данных. https://octoparse.com/

ParseHub

ParseHub – это еще одна популярная платформа для автоматизации веб-сбора данных, которая предлагает аналогичные возможности Octoparse, но с более продвинутыми функциями для обработки сложных веб-сайтов. ParseHub использует алгоритмы машинного обучения для автоматического обнаружения и извлечения данных с веб-страниц, даже если структура сайта часто меняется.

Пример использования: сбор информации о вакансиях с различных сайтов поиска работы. ParseHub позволяет создать сборщик данных, который будет автоматически собирать информацию о вакансиях, требованиях и условиях работы, а затем сохранять ее в базе данных.

Преимущества: Продвинутые алгоритмы машинного обучения, поддержка сложных веб-сайтов, мощные возможности для обработки данных. https://parsehub.com/

Apify

Apify – это платформа для автоматизации веб-задач, которая предлагает широкий спектр инструментов для сбора данных, тестирования веб-сайтов и создания веб-скрейперов. Apify позволяет использовать готовые веб-скрейперы, созданные другими пользователями, или создавать собственные скрипты на JavaScript.

Пример использования: сбор данных о социальных сетях. Apify позволяет создавать скрипты, которые будут автоматически собирать информацию о пользователях, постах и комментариях в социальных сетях.

Преимущества: Гибкость, поддержка JavaScript, большой выбор готовых веб-скрейперов. https://www.apify.com/

Diffbot

Diffbot – это платформа для автоматического извлечения структурированной информации с веб-страниц. Diffbot использует алгоритмы машинного обучения для определения ключевых сущностей на веб-страницах, таких как товары, компании, люди и события, и извлекает информацию об этих сущностях в структурированном формате.

Пример использования: извлечение информации о продуктах с веб-сайтов интернет-магазинов. Diffbot позволяет автоматически извлекать информацию о названии продукта, цене, описании и характеристиках, а затем сохранять ее в базе данных.

Преимущества: Автоматическое извлечение структурированной информации, высокая точность, поддержка различных типов веб-сайтов. https://www.diffbot.com/

Scrapy

Scrapy – это мощный и гибкий фреймворк для веб-скрапинга на Python. Scrapy предоставляет широкий набор инструментов для создания сложных сборщиков данных, а также позволяет использовать сторонние библиотеки для обработки данных и хранения информации. Scrapy требует знания Python, но предлагает максимальную гибкость и контроль над процессом сбора данных.

Пример использования: сбор данных для исследовательских проектов. Scrapy позволяет создавать сложные сборщики данных, которые могут собирать информацию с нескольких веб-сайтов и обрабатывать ее различными способами.

Преимущества: Гибкость, мощь, поддержка Python, большое сообщество разработчиков. https://scrapy.org/

Выбор подходящего поставщика: на что обратить внимание

Выбор подходящего поставщика программного обеспечения для платформ удаленного сбора данных – это ответственный шаг. Важно учитывать не только функциональность платформы, но и ее стоимость, удобство использования, поддержку и безопасность. Также стоит обратить внимание на отзывы других пользователей и сравнить разные платформы, прежде чем принимать окончательное решение.

Не забудьте также учесть особенности ваших задач и требований. Если вам нужно собирать данные с простых веб-сайтов, то вам может подойти платформа с визуальным интерфейсом, такая как Octoparse или ParseHub. Если вам нужно собирать данные с сложных веб-сайтов или извлекать структурированную информацию, то вам может подойти платформа с продвинутыми алгоритмами машинного обучения, такая как ParseHub или Diffbot. А если вам нужно максимальное гибкость и контроль над процессом сбора данных, то вам может подойти Scrapy.

Заключение

Платформы уда

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

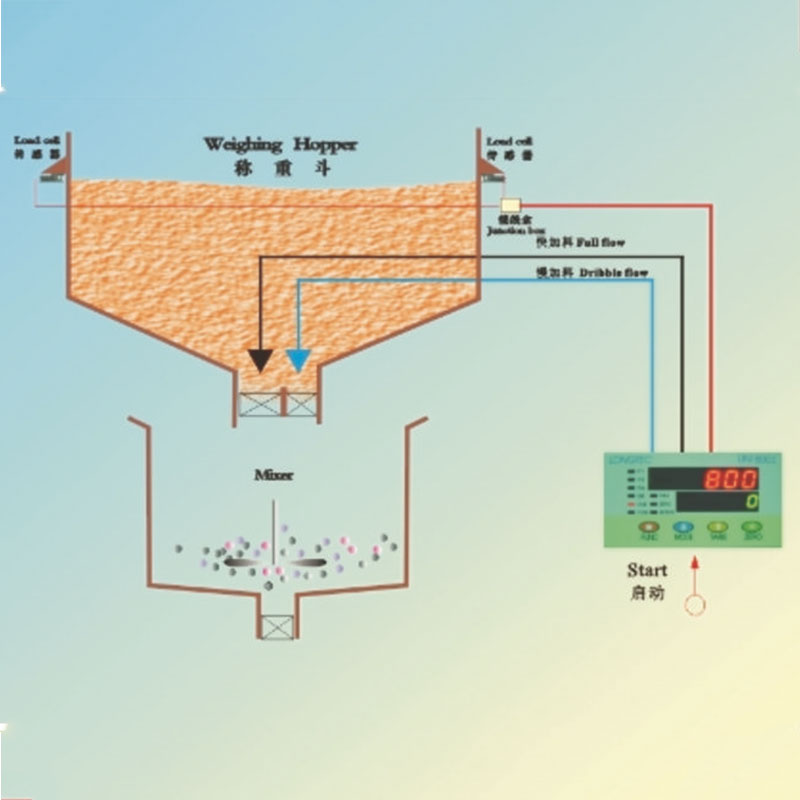

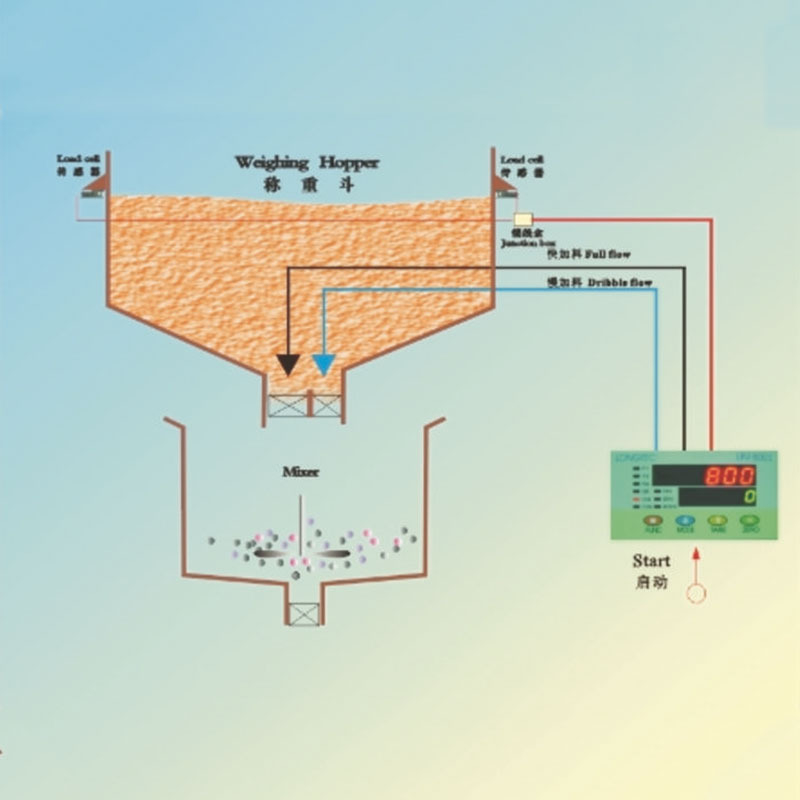

Одномасштабная система дозирования одного сорта

Одномасштабная система дозирования одного сорта -

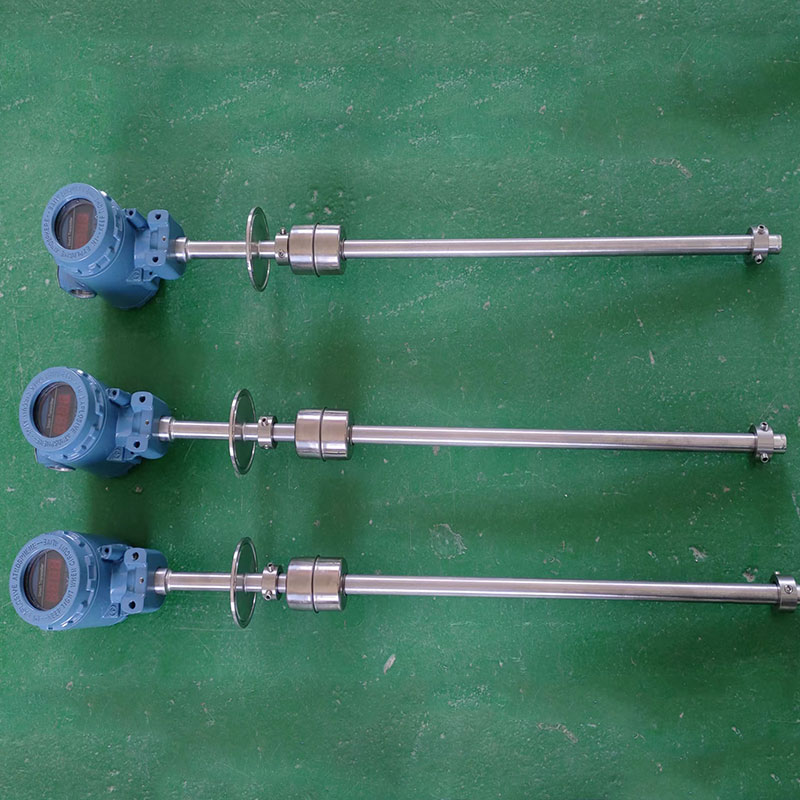

Измеритель температуры

Измеритель температуры -

Измеритель для контроля взвешивания

Измеритель для контроля взвешивания -

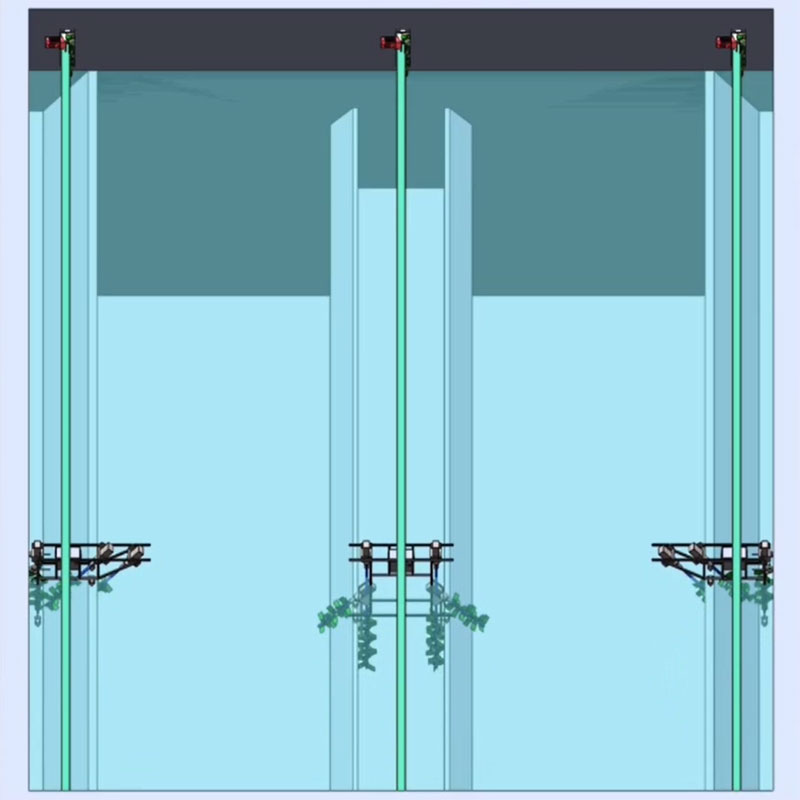

Измеритель уровня жидкости

Измеритель уровня жидкости -

Робот-уборщик AUTOMAN MAN-JSIII типа

Робот-уборщик AUTOMAN MAN-JSIII типа -

Тензодатчик

Тензодатчик -

Невесомые весы, различные разновидности пропорциональной системы распределения управления

Невесомые весы, различные разновидности пропорциональной системы распределения управления -

Центральная система управления и большой светодиодный экран

Центральная система управления и большой светодиодный экран -

Манометр

Манометр -

Распределительный шкаф ИБП распределительная коробка

Распределительный шкаф ИБП распределительная коробка -

Система точного дозирования лекарственных средств типа GPS-FT-I (порошкообразных)

Система точного дозирования лекарственных средств типа GPS-FT-I (порошкообразных) -

Шкаф управления ПЛК

Шкаф управления ПЛК

Связанный поиск

Связанный поиск- Поставщик s-образных тензодатчиков

- Поставщики шкафов распределения питания

- Купить количественная упаковка машина

- Цены на программное обеспечение для платформ удаленного сбора данных

- Купить производителя систем контроллеров автоматизации

- Производители датчиков давления

- Производители систем scada

- Высококачественные производители манометров типа 5

- Производитель высококачественных весов

- Радиальные манометры из китая